Melyek a legfontosabb SEO alapok? (Frissítve, 2023.10.31.)

I. Feltérképezés és indexelés

Felfedezés

Értékelés

- Alacsony minőségű tartalom – ez következhet például a kevés szövegből, duplikált tartalomból, túloptimalizáltságból, fekete kalapos SEO megoldásokból.

- Indexelési utasítások az oldalon – ezek a különböző robotoknak szóló jelzések, mint például a „noindex”, vagy egy másik oldalra mutató canonical URL jelenléte. A Google persze nem feltétlenül követi az utasításokat, csak megfontolja őket.

- Nem látható vagy hozzáférhető a botok számára a tartalom – ha például egy weboldal nagyon erősen a JavaScriptre épít, esetleg a tartalom túlságosan összetett és nem szokványos módon épül fel, akkor nem biztos, hogy fel tudja dolgozni a Google.

- Ha JavaScriptet kell feldolgoznia – ha egy nehéz JavaScripttel találja magát szemben, akkor a Google halasztja a feltérképezést. Ez az idő változó, a Google kapacitásaitól és az oldal besorolásától függ.

Indexelés

Ha az előbbi lépéseknél nem volt gond, akkor az oldal tartalmát indexeli a Google, így az bekerül a találati oldalakra. Ezt leellenőrizheted a Search Console-ban, ha rákeresel az új oldal linkjére, vagy akár a Google-keresőben is a site: operátorral az URL előtt.

Azt azonban ne felejtsd el, hogy azért mert egy oldal egyszer indexelésre került, még nem feltétlenül marad indexelt örökké. A Google újra és újra feltérképezi és újraértékeli az oldalak tartalmát. Ha például a tartalom minősége valami oknál fogva romlik, vagy fellép egy technikai tényező, mely ellehetetleníti a hozzáférést, akkor az oldal ki fog esni az indexből.

Mennyire fontos tényező az indexelésnél az oldal minősége?

Habár az előbbiekben már többször említettük, lehet, hogy mégis átsiklottál afelett, hogy gyenge minőségű tartalom esetében nem kerülnek indexelésre oldalak. Ennek kapcsán 2020 májusában nyilatkozott is John Mueller, a Google szakembere, jelezve, hogy az indexelési panaszok esetében általában azzal találkozik weboldalaknál, hogy azok minősége nem üti meg a Google által elvárt szintet, nem pedig technikai problémáról van szó. Mint mondta, az algoritmus áttekinti a weboldalt, illetve annak bizonyos részét, és sok esetben azt állapítja meg, hogy nincs értelme indexelni az oldalakat.

Ez egyébként egy olyan kérdésre válaszolva mondta, ahol a kérdező a rossz belső linkstruktúrában kereste az indexelési probléma forrását, vagyis abban, hogy a blogbejegyzéseik mindössze hónapok alapján voltak rendezve, nem használtak kategóriákat, illetve ezen túl mindössze némi szövegen belüli linkelés volt más, kapcsolódó bejegyzésekre. Mint kiderült, a Google első körben indexelte az oldalakat, de aztán kiestek az indexből.

Erre mondta azt John Mueller, hogy ha egyszer sikerült feltérképezni az oldalakat, akkor nem az a probléma, hogy nem elég jó a linkstruktúra, hanem általában az, hogy nem elég használhatóak ahhoz, hogy benne maradjanak az indexben. Mueller szerint ilyenkor érdemes megnézetni egy kívülállóval a weboldal tartalmát, hogy ő ítélje meg, vajon az egyes tartalmak egyáltalán nem releváns témákról szólnak, vagy valamikor azok voltak, de mára veszítettek jelentőségükből. Vagy talán az is előfordulhat, hogy nagyon hasonlítanak más weboldalakon található tartalmakhoz. Egy külső fél mindenesetre kritikusabban képes szemlélni a weboldalt, így könnyebben rámutat a lehetséges minőségbeli problémákra.

Az oldaladnak át kell mennie a minőségi teszten, hogy indexelésre kerüljön

Az előbb elmondottakat megerősítette Gary Illes is, a Google másik szakembere a Redditen, ahol jelezte, hogy egy oldal indexeléséhez arra van szükség, hogy átmenjen a minőségi ellenőrzésen. Ha viszont nem megy át ezen a minőségi teszten, akkor lehet, hogy a Google nem fogja indexelni, még akkor sem, ha manuálisan – a Search Console-on keresztül – beküldöd az oldalt indexelésre a Google-nek.

Mindezt arra válaszul közölte, hogy egy weboldaltulajdonos a Redditen arra panaszkodott, hogy szerinte „nem működik” a Google Search Console-ban az indexelés kérelmezése funkció. Gary Illes szerint viszont működik, de attól, hogy beküldi indexelésre az oldalát, még nem feltétlenül fogja azt indexelni a Google. Hangsúlyozta, hogy nem is garantálják azt, hogy mindenképpen indexelésre kerül a kérelmezett oldal (hiszen a tartalomnak még előbb át kell mennie a minőségi ellenőrzésen, hogy indexelésre kerüljön sor).

Végül a weboldaltulajdonos azon kérdésére, hogy akkor mit csináljon, hogy a Google indexelje az oldalait, Gary Illes úgy válaszolt, hogy összpontosítson a tartalomra, és próbáljon meg javítani rajta. Azt is megjegyezte, amit korábban John Mueller is, hogy kérje meg néhány barátját, hogy mondjanak őszinte véleményt a weboldal tartalmáról, és fogadja meg a tanácsaikat.

Akkor sem biztos, hogy indexeli a weboldalad a Google, ha annak minősége kiváló (FRISSÍTÉS, 2023.10.16.)

Hogy a helyzetet tovább bonyolítsuk: lehet, hogy jó minőségű az oldalad, illetve annak tartalma – és még a Google is annak látná -, emellett technikailag is rendben van, mégsem kerül indexelésre.

Eddig ugye arról volt szó, hogy ha egy weboldal nem kerül indexelésre, viszont technikai szinten rendben van, akkor annak a minőségével lehet probléma, mivel nem felel meg a Google keresési indexébe történő felvételhez szükséges minőségi követelményeknek.

John Mueller azonban 2023 szeptemberében úgy nyilatkozott a témában, hogy még a jó minőségű oldalak esetében sem garantált az indexbe kerülés.

A Google szakembere az X-en úgy fogalmazott, hogy „egy oldal lehet kiváló minőségű, mégsem kerül indexelésre – ez nincs garantálva”. Azt is hozzátette, hogy ugyanígy nincs garancia arra sem, hogy egy korábban indexelt oldal a megfelelő minősége mellett mindig indexelve marad. Hogy miért? Mert tele van a web egy csomó jó, illetve megkérdőjelezhető „dologgal” – adott hozzá némi magyarázatot.

Ez alatt viszont inkább azt értette, hogy a Google sem tökéletes. Tehát elviekben nyilván minden kiváló minőségű oldalt fel akar térképezni, majd indexelni, de ez nem mindig történik meg, sőt olykor a korábban indexelt oldalak is kiesnek az indexből. Annak ellenére, hogy a minőségükkel nincs probléma.

Az is igaz ugyanakkor, hogy ha egy weboldalnál arra van szükség, hogy azt külön be kell küldeni indexelésre a Google-nek – miközben technikailag nincs vele semmi probléma -, akkor erős a gyanú, hogy annak tartalmi minőségével valami gond van.

Mi okozhat még problémát az indexelésnél? Alapvetően olyan technikai problémáka, mint

- a weboldal struktúrája – ha vannak olyan oldalaid, melyek más oldalaid felől nincsenek linkelve, akkor nehézséget okoz a botoknak hozzájuk férni. Természetesen külső linkekről is megtalálhatják, azonban összességében mégis feltérképezhetőségi problémát okoz egy ilyen strukturális hiba.

- Belső linkrendszer – a botok a linkeket követve térképezik fel a webet, így csak azokat az oldalakat találják meg, melyek valahonnan linkelve vannak. Egy jó belső linkrendszer révén még azokat az oldalaidat is könnyen elérik, melyek mélyen el vannak rejtve a weboldaladon. Ha viszont hiányoznak a megfelelő belső linkek, akkor zsákutcába futhat a bot, és nem találja meg bizonyos tartalmaidat.

- Hurkolt átirányítások – ha a bot törött átirányításokat talál, akkor azok megakasztják és nem fogja megfelelően feltérképezni az oldalaidat.

- Nem támogatott szkriptek és más technológiai tényezők – feltérképezési hibák adódhatnak az általad használt technológiákból is. Például a botok nem tudják követni a formokat, tehát, ha egy form mögé elrejtesz tartalmakat, akkor azokat nem látják. A Javascript és az Ajax szint okozhat hozzáférési problémát a botok számára.

- Blokkolt hozzáférés – szándékosan is korlátozhatod a botok hozzáférését bizonyos tartalmakhoz, így azokat nem tudják indexelni.

- Szerverhibák – a rossz szerver átirányítások és más szerverrel kapcsolatos problémák is megakadályozhatják a Googlebotot a weboldalad feltérképezésében. Azt is érdemes azonban tudni, hogy ha gyakrabban találkozik valamilyen 5xx-es hibával a weboldaladnál a Google, akkor elkezdi csökkenteni az indexelés gyakoriságát.

A legtöbb weboldal esetében ilyen szerverhibák csak egy rövid időre jelentkeznek: például, amikor leáll a hosting szolgáltatás vagy frissítésre kerül a CMS. Ezzel nincs gond, mert minden weboldalnál jelentkezik egyszer-egyszer. Ugyanakkor vannak olyan weboldalak, ahol a szerverhibák krónikussá válnak, ami azt jelzi a Google-nek, hogy gond van a weboldallal. Például egy rosszul konfigurált tűzfal esetében kaphat 5xx-es hibát a Googlebot, de az is előfordulhat, hogy bizonyos országok felőli forgalom le van tiltva, és a Googlebot pont onnan érkezik indexelni.

A lényeg, hogy ha a Search Console szerverhibákat jelez, akkor utána kell járni annak, hogy valami ideiglenes problémáról van-e szó, vagy pedig nagyobb horderejű az ügy. Ha a Search Console-ban állandósul a hibák jelzése, akkor érdemes megnézni, hogy miként látja a weboldalt a Google, ami segíthet abban is, hogy megtaláld a hiba okát.

Ha a szerverhibák nem túl régóta fordulnak elő, akkor a Google időnként visszanéz az oldalra, hogy lássa, megoldod-e a problémákat. Ugyanakkor ritkábban kerít sort a feltérképezésre a bot, és a korábbi rendszeresség csak akkor áll vissza, ha már nem tapasztal hibákat. Erre itt utal John Mueller: That’s a very vague question, and a post from 2016, it makes it a bit hard to guess :). We do crawl old 404 pages from time to time, that’s nothing to worry about. It’s more problematic if they’re 5xx errors (we slow crawling), or if the URLs were meant to be indexed. — John ☆.o(≧▽≦)o.☆ (@JohnMu) 2018. július 9.

Hogyan tedd a weboldalad könnyen feltérképezhetővé és indexelhetővé?

- Küldd be a webhelytérképet a Google számára – a webhelytérkép egy kis fájl, mely a domained gyökérkönyvtárában található, és direkt linkeket tartalmaz minden egyes aloldalhoz. Ezt a Search Console-on keresztül tudod elküldeni a Google-nek.

- Erősítsd meg a belső linkeket – kapcsolj össze minden tartalmat, hogy növeld az esélyét a Googlebot megfelelő hozzáférését.

- Rendszeresen frissíts és adj hozzá új tartalmakat – a tartalom a weboldalad legfontosabb része, de a feltérképezésben is segít. A botok gyakrabban látogatják azokat az oldalakat, ahol gyakoribbak a frissítések.

- Kerüld a duplikált tartalmakat – a duplikált tartalmak kérdése nem egyszerű, egy külön bejegyzésben már foglalkoztunk vele.

- Gyorsítsd fel a weboldalad – a botoknak csak korlátozott idő áll a rendelkezésükre ahhoz, hogy feltérképezzék és indexeljék a weboldaladat. Ez az úgynevezett feltérképezési büdzsé. Vagyis minél gyorsabb a weboldalad, annál több oldalt tudnak feltérképezni a botok.

Hogyan ellenőrizd, hogy indexelte-e a weboldalad a Google?

Ha megtettél mindent a weboldalad indexelhetősége érdekében, akkor nyilván kíváncsi vagy arra is, hogy indexelte-e vajon a Google. De hogyan ellenőrizd? Szerencsére a dolgodat a keresőóriás is megkönnyíti:

- egyszerűen csak lépj be a Google-keresésbe,

- majd üsd be a keresőmezőbe a „site:” paraméter után az URL-t a https nélkül (pl. site:webshark.hu).

- Ekkor a találati oldalon látnod kell az indexelt oldalt vagy oldalakat.

Ha mégsem látod, akkor bizony azt az oldalt még nem indexelte a Google.

A másik lehetőség, ha a weboldal tulajdonjoga a Tiéd, hogy

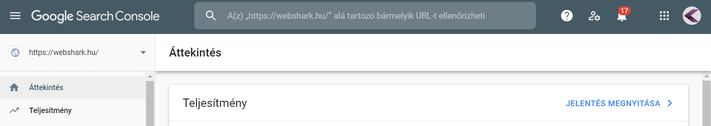

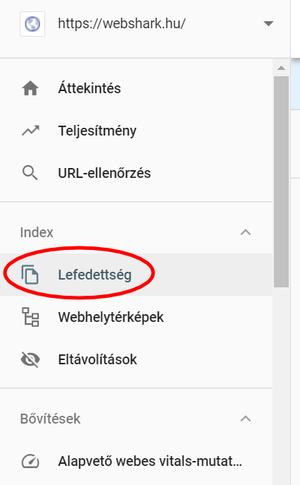

- belépsz a Search Console felületére,

- itt az „Index” részben lévő „lefedettség” menüpontra kattintasz,

- majd láthatod az indexelt oldalak számát.

Ha a szám nulla lenne, akkor még semmit nem indexelt a weboldaladból a Google. Ha azt látod, hogy jó pár oldalad nem került indexelésre, akkor nem kell mindjárt aggódnod, ez egyrészt normális, másrészt ellenőrizni kell a részleteket a nem indexelt oldalak kapcsán, hogy hibáról lehet-e szó. Erről egy későbbi fejezetben részletesebben is írunk.

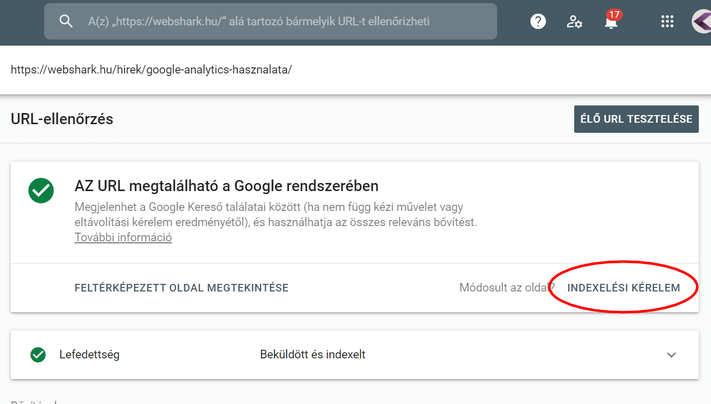

Azt is le tudod persze ellenőrizni, hogy egy bizonyos oldaladat indexelte-e a Google: ehhez csak kattints rá egyből a belépés után a Search Console legtetején lévő keresőmezőre (ez az úgynevezett URL-ellenőrző eszköz), ahová illeszd be az ellenőrizni kívánt URL-t! URL-ellenőrző eszköz a Search Console-ban URL-ellenőrző eszköz a Search Console-ban

Milyen gyorsan kellene indexelnie a weboldaladat a Google-nek? És hogyan tudod ezt felgyorsítani?

A Google számára néhány naptól néhány hétig terjed az az időszak, melyen belül még normálisnak tekinthető az indexelés elhúzódása. Persze, ha hetekig tart egy újonnan indult oldal indexelése, akkor az egy kicsit idegesítő lehet. Szerencsére azonban vannak lehetőségek a folyamat gyorsítására.

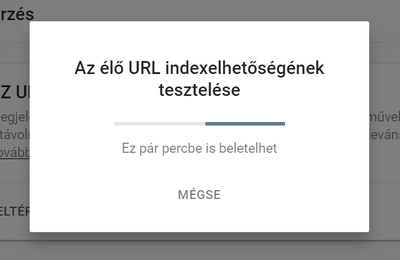

A legegyszerűbb a már előbb bemutatott funkció használata: az URL-ellenőrző eszköz használata, ahol kérelmezheted is, hogy indexelje vagy újra indexelje az oldaladat a Google, ha valami változás történt rajta. Ehhez csak kattints rá a jobb alsó sarokban lévő „Indexelési kérelem” feliratú linkre:

És máris beindul a folyamat:

Ez tényleg eltart egy darabig, nem kell türelmetlennek lenni. A végén ezt a visszajelzést kapod:

A manuális indexelési kérelmezéssel ugyan voltak problémák az elmúlt időszakban (konkrétan hónapokig nem működött), azonban 2020 legvégére a Google – ígéretének megfelelően – rendbe rakta, így ismét használható.

Frissítés, 2022.11.24.:

Hogyan tudod felgyorsítani a weboldalad indexelését? Egy másik módszer

Egy másik lehetőség, amit a Google is javasol, az a Google megpingelése a weboldaltérképpel. Itt arról van szó, hogy ha a weboldalad frissítetted, mert mondjuk egy új tartalom jelent meg rajta egy új oldallal, akkor a pingelés a weboldaltérképpel gyorsítani fogja az indexelést. Ezt a Google szakembere, John Mueller mondta tanácsként a Twitteren.

Mint jelezte, egy webhelytérkép pingelése különbözik attól, hogy a robots.txt-ben jelzed a változást. A pingeléssel ugyanis aktívan jelzed a weboldaltérképben bekövetkezett változást. Vagyis, ha azt szeretnéd, hogy az új tartalmad gyorsabban indexelje a Google, akkor ez egy jó megoldás – tette hozzá.

A Google egyébként fejlesztőknek szóló dokumentációjában is világossá teszi, hogy nem ellenőrzi minden esetben a weboldaltérképet, amikor a weboldalon jár. A webhelytérképet az első alkalommal ellenőrzi, amikor észleli, illetve legközelebb akkor, megpingeled őket amiatt, hogy változott valami benne. Ugyanakkor ezt csak akkor érdemes megtenni, ha valami új dolog került az oldaltérképbe, vagy valami frissítve lett, tehát ne pingeld a Google-t akkor, ha semmi nem változik az oldaltérképen.

És, hogy hogyan működik a pingelés? Például úgy, hogy egyszerűen beírod a böngészőbe ezt az URL-t: https://www.google.com/ping?sitemap= , majd utána szóköz nélkül az oldaltérképed teljes URL-jét.

Milyen gyakran kellene indexelnie a weboldaladat Google-nek?

Amikor a weboldalak feltérképezéséről van szó, akkor akadnak olyan oldalak, melyeket sűrűn, akár naponta többször is átnéz a Googlebot, más oldalak esetében viszont akár hónapok is eltelhetnek két látogatás között. De mikor adhat okot aggodalomra az indexelés gyakorisága? Erre John Muller, a Google szakembere adott válaszokat.

Először is, jelezte, hogy a rendszeres feltérképezés nem követelménye annak, hogy egy oldal rangsorolva legyen és megjelenjen a találati oldalakon. Tehát, csak azért, mert nem nézi át naponta, hetente vagy havonta a weboldalad a Google, még nem fog kiesni az oldalad a keresőből.

Ugyanakkor bizonyos URL-ek ritka feltérképezése jelezhet minőségi problémákat. Akadnak olyan weboldalak – például alacsony minőségű linkekkel -, melyeket ritkán látogat újra a Google, mintegy büntetésként. Az is előfordulhat, hogy azonos vagy hasonló tartalom miatt szűr ki oldalakat az újra-feltérképezésből a Google. John Mueller pedig arra is felhívta a figyelmet, hogy különösen webáruházaknál nagyon sok az úgymond „felesleges” URL. Viszont az is igaz, hogy a Google a jó minőségű, de örökzöld weboldalakat is ritkábban vizsgálja újra, különösen, ha azok statikus oldalak, melyeken semmiféle változás nem látható, amikor a bot ott jár.

A lényeg tehát az, hogy azért, mert vannak olyan oldalaid, melyeket ritkán indexel a Google, az nem jelenti azt, hogy nem fogja megmutatni az embereknek, vagy ne rangsorolná őket. Ugyanakkor persze érdemes kizárni az okokat, melyek egy esetleges ritka indexeléshez vezetnek.

Mi van, ha nem indexeli valamennyi oldalad a Google?

Ha amiatt aggódsz, hogy a Search Console-ban azt látod, hogy nem minden weboldalad indexeli a Google, akkor nem biztos, hogy gond van. A Google olykor nem indexeli valamennyi weboldalad, ami az oldaltérképen szerepel. Valamennyi ebből elfogadható, ugyanakkor lehet komolyabb is a probléma, és állhat mögötte technikai vagy épp tartalmi, minőségbeli probléma.

Például, ha WordPresst használsz, akkor minden tagnek van egy külön oldala. Ezek között sok olyan van, melyek alatt nagyjából ugyanazok a címek sorakoznak. Ezért a Google nagy valószínűséggel ezek közül kiszűri azokat, melyeknek azonos a tartalma. A legtöbb oldal azért kerül kiszűrésre az indexeltek közül, mert azonos vagy nagyon hasonló a tartalma, mint egy másik oldalnak.

- Ilyenkor talán megéri ellenőrizni és meghatározni azt a canonical tag alkalmazásával, hogy melyik oldalt jelöljük eredetinek.

- Emellett arra kellene még egy pillantást vetni, hogy az új oldalak, melyek hozzá lettek adva az oldaltérképhez, indexelésre kerülnek-e.

A Google tájékoztatást ad a Search Console-ban arról, hogy hány darab URL-t indexel a beküldött oldaltérképen szereplők közül. Azt ugyanakkor nem jelzi, hogy melyek azok, amelyeket nem indexel. Ha valakinek van egy nagyméretű weboldala, és annak egy részét nem indexeli a Google, akkor az oldaltérkép felosztásával könnyebb megtalálni azt, hogy ez mely oldalakat érinti.

Nyilván persze a nem indexelés mögött állhatnak technikai problémák, valamiért a Google nem fér hozzá az oldalhoz. Ugyanakkor a másik lehetőség, hogy tartalmi minőségbeli gondok vannak. A Google azt mondja ennek kapcsán, hogy ha rendszeresen be kell küldened indexelésre egyes oldalakat, akkor ott komoly gond van, és feleslegesen indexelteted az oldalakat.

John Mueller Twitter bejegyzésben úgy fogalmazott, hogy ha a normál tartalmaid kézi indexelésre szorulnak, akkor jelentős mértékben javítanod kell az oldalad minőségén. A Search Console ebben az esetben nem fogja megoldani a problémádat, neked kell azt megtenned.

Azt is megjegyezte, hogy az indexelés erőltetése nem fog jobb helyezést eredményezni, gyakorlatilag csak időpocsékolás. Mert minek is indexelteted az oldalt, ha aztán az nem fog jó helyen megjelenni a találati oldalakon? – teszi fel a kérdést. Tehát, ha azt tapasztalom, hogy az oldalakat nem indexeli a Google, akkor a Search Console-ban a technikai problémák ellenőrzése, majd javítása után kezdd el a tartalmakat/oldalakat fejleszteni. If your site relies on manual index submission for normal content, you need to significantly improve your site. Search console does not fix your site, you need to do that yourself. — ? John ? (@JohnMu) 2020. február 3.

A weboldaltulajdonosnak további teendője nincs. És főleg arra kell figyelni, hogy a különösen fontos oldalak indexelve legyenek a Google által. Ezt azonban könnyen észre lehet venni, ha ezek az oldalak nem hozzák a forgalmat.

Miért fordulhat elő az, hogy nem indexeli a főoldalad a Google?

Az alcímben feltett kérdésre nemrég a Search Off The Record podcastben válaszolt a Google három szakértője, Martin Splitt, John Mueller és Gary Illyes. Végigvették a technikai és nem technikai problémákat, melyek egy főoldal indexből való kiesését okozhatják.

A technikai okok kapcsán Illyes elmondta, hogy az új weboldalaknak, különösen a főoldalnak nagyon egyszerűnek kellene lennie az indexelés érdekében. Ha nem kerül indexelésre az oldal, akkor végig kell futni néhány lehetőségen:

- a weboldal elérhetetlen a Googlebot számára?

- a robots.txt blokkolja a Googlebotot?

- a főoldal URL-jét még semmilyen más oldal nem linkeli?

Az ellenőrzéshez meg kell nézni a szerver logokat, hogy a Googlebot próbálkozott-e indexeléssel. Ezután meg kell nyitni a robots.txt-t, ami meghatározza, hogy mely oldalakról van kizárva a Googlebot.

A canonical-megoldások is okozhatnak problémát, ha a főoldal át van irányítva egy másik oldalra, vagy más oldal van beállítva canonicalként. Ilyenkor a Google a canonical oldalt indexeli, nem a főoldalt. Ellenőrizni kell tehát, hogy van-e átirányítás a főoldalhoz kapcsolva.

Végül azt is meg kell nézni, hogy mutatnak-e linkek a főoldalra, akár weboldal aloldalairól is. Ha nem, akkor ott nagy gond van az oldal felépítésével, és sem a felhasználók, sem a Googlebot nem tudja használni.

Emellett előfordulhatnak nem technikai okok is: például, ha a főoldal még placeholder szöveget tartalmaz vagy fejlesztés alatt grafika látható még rajta. Ilyenkor a Google lehet, hogy nem indexeli az oldalt. Az is lehet azonban gond, ha a Google úgy ítéli meg, hogy alacsony minőségű a főoldal tartalma, spamnek tekinti.

Ha ezen hibák valamelyike fennáll, és azt kijavítod, utána nem fog azonnal megjelenni az találati oldalakon weboldalad. A Google ugyanis nem fogja azonnal indexelni, ellenőrizni az oldalt. Amíg ez meg nem történik, érdemes tovább javítani a technikai hátterét, a tartalmát, a felhasználói élményét – tanácsolta a szakértő.

A rövidebb szövegű oldalakat gyorsabban indexeli a Google?

Akad, akiben az indexelés gyorítása kapcsán felmerül az is, hogy talán rövidebb szövegeket lenne érdemes írni, mert azokat gyorsabban tudja indexelni a Google, mondván: kisebb erőfeszítésébe kerül egy rövidebb szövegen átrágnia magát a robotnak.

Az ezzel kapcsolatos kérdés valóban fel is tette egy weboldaltulajdonos Gary Illyesnek, a Google szakemberének egy Google office hours során. Ő azonban úgy válaszolt: a tartalom hosszúsága nem befolyásolja a feltérképezési gyakoriságot és az indexelést.

Mivel a kérdésben az is felmerült, hogy a konkrét esetben egy rövid, de úgynevezett „niche” – tehát a közönség egy szűkebb, speciális körének szóló – tartalomról van szó, azt is megjegyezte, hogy ugyan a niche tartalmakat is indexelik, azonban az általános, népszerű tartalmakat – például amelyeket többen linkelnek – könnyebben feltérképezik és indexelik.

Tényleg csak 250 oldalt hajlandó indexelni a Google minden weboldalon?

Felmerült a minap egy furcsa kérdés John Muellernek címezve. A kérdező azt kérdezte, hogy „még mindig létezik-e a weboldalakra vonatkozó, 250 statikus oldalas limit”. Ami elsősorban a 250-es korlát miatt érdekes, hiszen a web tele van olyan weboldalakkal, melyeknek akár több millió statikus aloldaluk van, és a Google ezeket láthatólag indexeli. Gondolj itt a nagy híroldalakra, melyek rengeteg oldallal rendelkeznek, és némely weboldal akár naponta több ezer új oldallal bővül.

Tehát érdekes szám a 250, melyről azt sem igazán lehet tudni, hogy hannan származik, mindenesetre, ami ennél is fontosabb, hogy mit mond ezzel kapcsolatban John Mueller. Röviden és tömören azt, hogy „nincs korlát”. Ez valószínűleg azt jelenti, hogy a Google nem alkalmaz semmiféle korlátot az egyes weboldalak indexelése esetében, tehát senkinek nem kell aggódnia amiatt, hogy annyi aloldalt hoz létre, amit már a Google sem lesz képes indexelni.

Az eredeti kérdés és válasz itt olvasható: There is no limit. — ? John ? (@JohnMu) November 21, 2019

Mit tegyél, ha azt akarod, hogy valamely oldalad ne indexelje a Google?

Lehetnek a weboldaladnak olyan aloldalai is, melyeknek ugyan van céljuk, ez azonban nem az, hogy a találati oldalakon jól szerepeljenek, vagy hogy egyáltalán: ezek hozzák a forgalmat. Esetleg gond is lehet a találati oldali megjelenésből. Ilyenkor kifejezetten arra van szükséged, hogy az oldalt ne indexelje a Google. Mivel érheted ezt el? A noindex meta taggel. Ennek révén ugyanis nem indexeli az oldalad a Google.

Milyen oldalaidnál lehet szükséged noindex meta tagre?

Például tipikusan ilyenek a duplikált tartalmak. Egy ismétlődő tartalomnál jó megoldás, ha arra kéred a Google-t ne indexelje, mert így nem fog semmilyen gondot okozni.

Felmerülhet az igény az általad alacsony minőségűnek tartott, csekély érdeklődésre számot tartó oldalaknál is, melyeket amúgy sem értékelne a Google, és összességében csak „lehúznák” a weboldalad.

De ebbe a sorba tartoznak olyan oldalak is, mint a „köszönöm oldal”, az admin vagy a login oldalak. Nyilván utóbbi nem olyan esetekre vonatkozik, ahol az emberek ott lépnek be egy szolgáltatásba, mint ahogy mondjuk a Dropboxnál.

Emellett a belső keresési eredmények oldalait sem szeretné a találatok között megmutatni a Google, úgyhogy célszerű neked gondoskodnod arról, hogy ne is legyen megtalálható. Ugyanakkor arra figyelj, hogy ezeknél a linkek fontosak, így a nofollow meta taget ne alkalmazd!

Hogyan kezeli a Google a noindex meta taget? Mire kell figyelned?

Első körben azt érdemes átnézni, hogy miként áll hozzá a Google a noindex címke használatához, mert ebből kiderül, hogyan érdemes használni, illetve hogyan nem. Amit feltétlenül tudni kell, hogy

- hasonlóképpen értelmezi a noindexet, mint a 404-es válaszkódot,

- olyan oldalakon érdemes használni, melyeket a weboldaltulajdonos soha nem akar indexeltetni.

A Google fejlesztői oldal így fogalmaz a noindex meta tag kapcsán: „arra utasítja a keresőmotort, hogy nem mutassa meg az oldal a találati eredmények között”.

Ez ugyan nem említi, hogy hasonlóképpen kezeli, mint egy 404-es kódot, de John Mueller, a Google szakemberének egy válaszából ez derült ki. Mint mondta, „ha látunk egy oldalt, mely hosszú időn keresztül noindex jelzést kapott, akkor azt feltételezzük, hogy ez valami olyan, mint egy 404-es oldal, ezért nem kell olyan gyakran feltérképeznünk.”

Ebből tehát az következik, hogy nem érdemes „játszani” a noindex meta taggel: nem szerencsés, ha egy olyan oldalt, amit később indexeltetni akarsz, noindex címkével látsz el, illetve időnként leveszed és visszateszed a címkét.

Mikor lehet ez érdekes? Például akkor, ha van egy terméked, ami időnként elfogy, és ilyenkor azt szeretnéd, hogy ne jelenjen meg a keresőben. Ezt ugyan megteheted, de mint látható, az nem megoldás, hogy hol noindex jelölést kap, hol pedig nem.

Ehelyett például érdemes inkább a strukturált adattal (ItemAvailability) megjeleníteni, hogy egy termék kapható vagy sem a webáruházadban. Ebben az esetben a keresőmotorok ezt értelmezni tudják, így nem jelenítik meg a keresési eredmények között, miközben továbbra is indexelik.

Egy másik kérdés, hogy

Bünteti-e a Google, ha sok oldaladnál használod a noindex taget?

Az is elképzelhető, hogy azért nem indexeli valamely weboldaladat a Google, mert noindex taggel van ellátva. Elképzelhető, hogy véletlenül került oda, de általában szándékosan szokott megtörténni a dolog (legfeljebb időközben elfelejtetted). A noidexet többféle ok miatt is használhatod, például azért, mert van egy (vagy több) duplikált oldalad, melyeket nem szeretnél megjelentetni a keresőben. Esetleg a feltérképezési büdzsé miatt aggódsz, vagy talán az az oka, hogy úgy érzed, gondok vannak az adott oldalak minőségével.

Amit érdemes tudni, hogy ezeket az oldalakat a Google továbbra is feltérképezi az oldal minőségének megítélése érdekében. Ugyanakkor kérdés lehet az, hogy számít-e, ha a weboldal több oldalánál is noindex jelölést talál a kereső?

A kérdést szerencsére a Google Webmaster Help egyik fórumbejegyzésében megválaszolta Aaseesh Marina, a Google egyik szakembere. Az adott esetben arról volt szó, hogy az érintett weboldal 50 százaléka volt noindex taggel ellátva. A szakember azonban világossá tette, hogy „a noindex tag használata a weboldalad aloldalainak egy bizonyos százalékánál nem rontja le a maradék oldalt„. Ennek oka, hogy a Google minden egyes oldalt külön rangsorol a relevanciájuk és egyéb tényezők alapján. Ezért nem is kell aggódni semmilyen büntetés miatt, ami egy esetleges gyenge tartalmi minőség miatt érhet.

A lényeg tehát, hogy a noindex használata még nagyobb mennyiségű weblap esetében sem káros, nem befolyásolja a weboldal indexelt részének minőségét. Persze, ha a többi oldal esetében is gondok vannak a minőséggel, akkor a weboldalt érintheti a Panda vagy más minőségi algritmusok hatása.

És mikor vesd be a nofollow metát?

A Google azt javasolja, hogy olyan linkeket jelöld meg a nofollow taggel, melyek

- fizetett linkek vagy

- nem megbízható tartalomra mutatnak.

Tipikusan ilyen linkek a kommentekben elhelyezett linkek (ezért is felesleges hozzászólásokban megjelenített linkeket használni SEO-ra). Valamint az olyan szövegekben elhelyezett linkek, melyeknek megjelenéséért fizettek.Hogyan gyorsíthatod meg, hogy egyes oldalaid lekerüljenek a Google találati oldalairól?

Mint láttuk, a noindex meta címke használható akkor, ha azt szeretnéd, hogy valamely oldalad ne indexelje a Google, így az ne szerepeljen a találati oldalakon. Bizonyos esetekben azonban szükség lehet arra, hogy ez gyorsan történjen, illetve néha sok oldalt érinthet ez a lépés. Például akkor, ha feltörték az oldalad, és a hacker több oldalad tartalmát módosította. De az is lehet, hogy termékeket vagy szolgáltatásokat már nem kínálsz a továbbiakban, esetleg egy új szabályozás miatt, bizonyos tartalmakat el kell távolítanod. Mi a megoldás?

Ha csak arról van szó, hogy néhány weboldalt szeretnél eltávolíttatni ideiglenesen a Google indexéből, akkor a legegyszerűbb módja ennek a Search Console-ban az URL eltávolító eszköz alkalmazása. Ennek használatáról itt ad bővebb tájékoztatást a Google.

Ugyanakkor bizonyos esetekben több száz oldal eltávolítása is szükséges lehet, így ez a módszer egy kicsit nehézkes lenne. John Mueller, a Google szakembere elmondta, hogy ilyenkor ideiglenes oldaltérképet érdemes használni. Tehát, először törlöd az oldalt (404-es oldal), vagy pedig noindexet állítasz be rá. Ezután feltöltesz egy ideiglenes oldaltérképet azokkal az URL-ekkel, melyeket töröltél, de szerepeljen benne a legutóbbi módosítás időpontja, azaz a 404-essé tétel vagy a noindex meta címke használatának időpontja is. Ezzel jelezheted a Google-nak, hogy nézzen rá az oldalakra, mert változtak. Amikor megtalálja a megváltozott oldalakat, illetve látja, hogy törlésre kerültek, akkor gyorsabban eltávolítja őket a találati oldalakról.

Képes-e a Google weboldalak részleges indexelésére?

Korábban már foglalkoztunk az alcímben feltett kérdéssel, miszerint képes-e a Google weboldalak részleges indexelésére. Akkor azt kellett mondanunk, amit John Mueller írt: a Google nem használ részleges, csak teljes indexelést. Mint tweetjében írta, weblapokat kizárólag, mint egészt indexelnek, és próbálják megérteni az ott talált tartalom kontextusát. We don’t index parts of a page independently, we index the pages as a whole, and try to understand the context of the content there. Scrolling to a part of a page when we know that’s where the snippet was from makes a lot of sense regardless of indexing. — ? John ? (@JohnMu) August 7, 2019

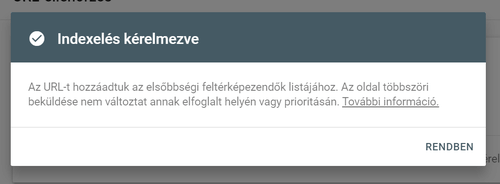

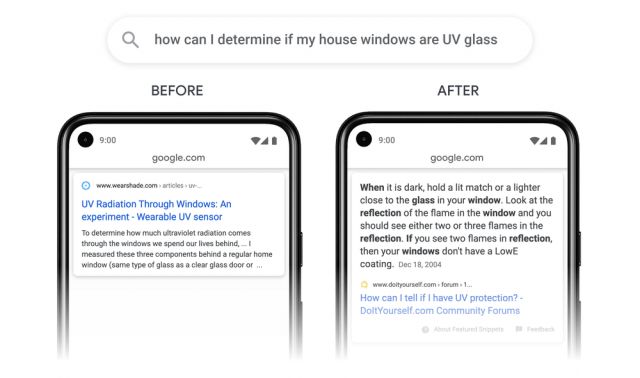

A dolgok azonban állandó változásban vannak, így a Google 2020. október 16-án bejelentette, hogy novembertől (fokozatos kifutással) már képes weboldalak részleges* indexelésére.

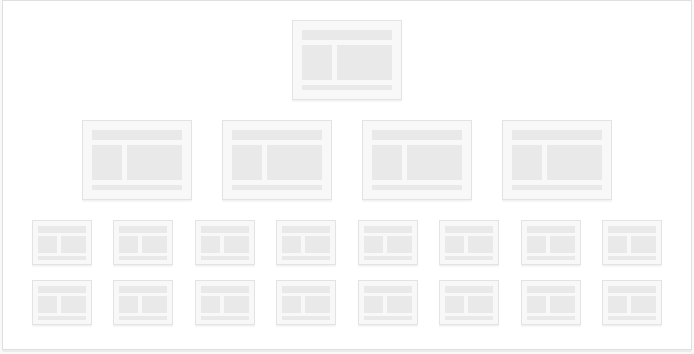

A Google bejelentésében úgy fogalmazott, hogy „áttörést értek el a rangsorolásnál”, és már nem csak teljes oldalakat tudnak indexelni, hanem a weboldalt szakaszokra tudják bontani, és szakaszonként értelmezni azt.

*Habár úgy fogalmaznak, hogy szakaszonként indexelnek, az indexelés továbbra is oldalanként történik, egyszerűen csak elkezdik külön értelmezni a szövegek egyes szakaszait. Tehát valójában nem az indexelés változik – még ha így is említik a bejelentésben -, hanem mindez a rangsorolásnál eredményez jelentős változásokat. (Elképzelhető, hogy emiatt az alcímek egyébként fontosabb jelzéssé válnak, de erről a Google egyelőre nem nyilatkozott.)

Mindez azért érdekes és fontos, mert miközben lehet, hogy egy teljes oldalad valamely keresésre nem igazán releváns, lehet benne egy olyan szakasz – tipikusan hosszabb, információs tartalmak esetén, mint amilyen például ez a bejegyzés is -, ami releváns választ ad egy felhasználó kérdésére.

Az is mutatja, hogy nagy horderejű változásról van szó, hogy a bejelentés szerint a keresések 7 százalékát érinti, minden nyelven, globálisan. Mint mondták, most már könnyebben megtalálja a Google a tűt a szénakazalban. Az alábbi ábrával illusztrálták mindezt: Szakaszos indexelés

Magyarázatként pedig egy példát is hozzátettek. E szerint, ha valami olyan niche témára keresel rá, mint hogy „hogyan állapítsam meg, hogy az ablaküvegeim UV-szűrősek”, akkor kapsz egy rakás oldalt, ami az UV-üvegekről szól, de konkrét választ nem kapsz a kérdésedre. Az új algoritmus viszont már képes megjeleníteni egy pontos válasz, mert már valamelyik DIY-fórumon talál egy leírást.

Frissítés, 2021.08.25.:

Mit jelentenek az egyes HTTP állapotkódok? És hogyan befolyásolják az indexelést és feltérképezést?

Lehet, hogy mindez már ismerős lesz számodra is, de soha nem árt felfrissíteni a tudást, különösen, hogy a Google nemrég egy új összefoglalót tett közzé az állapotkódokról. A Google információs anyaga a 20 legfontosabb státuszkódot sorolja fel, melyeket figyelembe vesz a Googlebot.

Amit elúljáróban érdemes tudni, hogy a HTTP állapotkódokat a szerver hozza létre, amikor egy weboldalt lekér a böngésző vagy a bot. Tehát például, ha a böngésző egy olyan tartalmat szeretne megjeleníteni, mely már nem létezik a szerveren, akkor az egy 404-es jelzést küld.

Az állapotkód első száma mindig a kategóriára utal: minden 2-vel kezdődő kód sikeres feltérképezést jelez, a 3-mal kezdődő kódok átirányításra utalnak, és így tovább. Nézzük meg ezeket egy kicsit részletesebben!

HTTP 2xx állapotkódok (sikeres feltérképezés)

Ezek azt jelzik, hogy a Googlebot fel tudja térképezni a tartalmat, és képes továbbítani azt indexelésre. A Google ugyanakkor felhívja a figyelmet arra, hogy egy 2xx állapotkód esetében sem feltétlenül indexel, mindössze arról van szó, hogy nincs hiba a weboldalnál.

Ez sem igaz azonban teljesen, mert a 204-es kód például azt jelzi, hogy az oldal ugyan elérhető, azonban nem található rajta tartalom. Ezért a Google a 204-es kód esetében puha 404-es oldalt jelez a Search Console-ban.

HTTP 3xx állapotkódok (átirányítások)

Ezeknél azt érdemes tudni, hogy nem minden átirányítás azonos erejű.

A 301-es állapotkód egy erősebb jelzés a Google számára, mint a 302, 303 vagy a 307-es kód. Ezek egyébként arra adnak utalást a robot számára, hogy melyik az eredetinek tekinthető oldal, amit figyelembe kellene vennie. A 304-es kód még érdekes, ugyanis az azt jelzi, hogy az oldal tartalma ugyanaz, mint a legutóbbi feltérképezés esetén. Ennek nincs hatása az indexelésre, de jelezheti azt, hogy az URL-t újra kell értékelni.

A Googlebot egyébként 10 átirányítást hajlandó figyelembe venni, mielőtt feladná az átirányítási lánc követését. Ha 10 átirányítás után sem talál tartalmat, akkor a Search Console átirányítási hibát jelez.

HTTP 4xx állapotkódok (kliensoldali hiba)

A 4xx-es hibakódot küldő oldalakat nem fogja indexelni a Google. A 429-es kód kivételével ez minden 4xx-es kódra igaz, melyek alapvetően azt jelzik, hogy egy tartalom nem létezik. Ha a tartalom korábban létezett, akkor az URL eltávolításra kerül a Google keresési indexéből.

A 429-es állapotkód viszont azt jelzi, hogy a bot nem tud hozzáférni egy oldalhoz, mert a szerver túlterhelt. Az ilyen URL-ek ezért nem kerülnek törlésre, hanem maradnak a Google indexében.

HTTP 5xx állapotkódok (szerverhibák)

Az 5xx-es státuszkódok hatására a Googlebot ideiglenes lassítja a feltérképezést. Azok a korábban indexelt URL-ek, melyek többször is szerverhibát küldenek a botnak egy idő után törlésre kerülnek az indexből.

További részletek a Google anyagában érhetők el.

Frissítés, 2021.10.19.:

Hogyan befolyásolja egy 500-as hibakód az indexelést?

Azaz, milyen körülmények között dobja ki az indexéből a weboldalt, illetve térképezi fel kevesebbszer a Google 500-as hibakód esetében? Erre John Mueller válaszolt egy videóban.

Az 500-as hibakód azt jelzi, hogy egy weboldal lekérése sikertelen. Egyszerűbben megfogalmazva, korábban ez volt az 500-as hibakód által adott üzenet: „500 Internal Server Error”. Szerverhibáról van tehát szó, melynek többféle verziója létezik, és ezek mindegyike valamilyen eltérő okra hivatkozik. A lényeg azonban az, hogy a weboldal lekérése sikertelen, legtöbbször azért, mert a szerver nem elérhető.

A weboldaltulajdonosok számára ez sokszor csak úgy derül ki, hogy a Search Console-ban találkoznak a figyelmeztetéssel, hogy valami hibát észlel a Google az oldalon. Néha mindössze annyi az oka, hogy a szerver jelentős terhelés alatt van. De lehet a Content Delivery Network (CDN) rossz beállítása is a háttérben, mely a Google-t is blokkolja az oldalak elérésében.

Ahhoz, hogy 500-as hibaüzenetek miatt kikerüljön egy weboldal a Google indexéből, hosszú ideig és folyamatosan 500-as hibákat kell kapni. A Google egy 500-as hiba esetén újra és újra próbálkozik a weboldalt elérni, de egy idő után elkezdi lassítani ezt, majd ha továbbra is sikertelen az oldal elérése, akkor kikerül az indexből. John Mueller szerint, ha csak néha produkál 500-as hibát egy oldal, annak nincs semmilyen következménye.

Azt is elmagyarázta, hogy első körben miért csökkenti a feltérképezési próbálkozások előfordulását a Google: mert lehetségesnek tartják, hogy maga a Google okozza a problémát a túl sok feltérképezési próbálkozással. Ha mégis azt látják, hogy nem tér magához az oldal, akkor viszont ejtik az indexből.

Azt azonban nem tudta megmondani, hogy pontosan mikor kezdi csökkenteni a feltérképezés gyakoriságát a bot, illetve mikor dobja ki az indexből, mert erre nincsenek fix értékeik.

Soha ne blokkold a 404-es oldalaidat a Googlebot elől!

Ezt John Mueller, a Google szakembere javasolja, mert „mindenféle problémát okoz”. Mint mondta, nem kellene megakadályozni a Googlebotot vagy bármely más keresőmotort abban, hogy 404-es oldalakba fusson bele a weboldaldon. A feltérképezésnél egyébként mindig vannak olyan URL-ek, melyek korábban 404-esek voltak – tette hozzá.

Ugyanezt egyébként egy másik tweetjében is megerősítette, amikor arról írt, hogy naponta több milliárd 404-es oldalt térképeznek fel, és ez egy teljesen normális része a webnek, a megfelelő megoldás arra, hogy jelezzük, amikor egy URL már nem létezik. Ez nem egy olyan dolog, amit meg kellene vagy meg tudnál változtatni – jegyezte meg.

A lényeg tehát, hogy a 404-es oldalakkal alapvetően nincs probléma, hiszen ahogy oldalak jönnek létre a weben, úgy oldalak meg is szűnnek, ezt pedig tudja kezelni a Google, és nem is bünteti, hiszen természetes jelenség. A 404-es oldalakról itt írtunk részletesen.

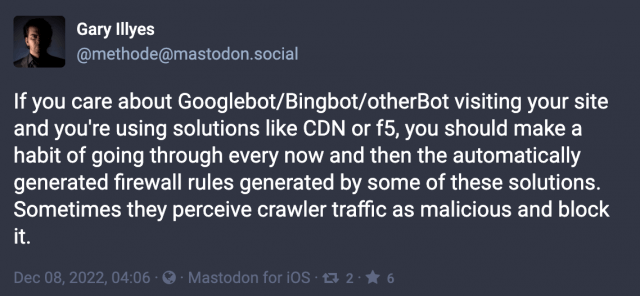

Ha CDN-t használsz, rendszeresen ellenőrizd, hogy hozzáfér-e a weboldaladhoz a Googlebot!

Erre Garry Illyes, a Google szakembere hívta fel a figyelmet a Mastodonon. Mint írta, ha fontos számodra, hogy a Googlebot/Bungbot/bármilyenbot meglátogassa az oldaladat, miközben olyan megoldásokat használsz, mint a CDN vagy f5, akkor váljék szokásoddá, hogy végignézed az ezek által automatikusan generált tűzfal-szabályokat. Ugyanis néha a botok által képzett fogalmat rosszindulatónak tekintik és blokkolják.

Ez egyébként is hasznos gyakorlat a weboldalak esetében, vagyis érdemes előre eltervezett időpontokban rutinellenőrzéseket végezni akár manuális, akár automatikus módon.

Így kiderülhet például, hogy a Googlebot blokkolva van, és megelőzhető az a probléma, hogy nem érted, miért esett vissza a keresőből érkező forgalmad.

De nem csak ezzel, hanem bármi mással is gond lehet, például nem működik valamelyik űrlapod a webáruházadban, és nem tudnak az emberek rendelést leadni. Amire csak akkor döbbensz rá, miután egy csomó pénzt veszítettél a hiba miatt. Ezért hasznos a rendszeres rutin- vagy akár automatizált ellenőrzés.

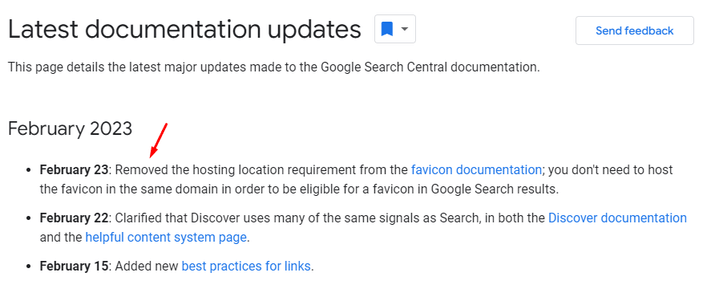

Frissítés, 2023.02.14.:

Tartsd tisztán a weboldalad kódjában a head részt!

Egy további fontos tényező a weboldal feltérképezhetősége és indexelhetősége kapácsán a head szekció. Ennek John Mueller szerint rendezettnek, tisztának kell lennie. Tehát, ha lehetséges, akkor ne legyen benne hibás szintaxis, mert az más részeit is tönkreteheti az oldalnak, illetve nehezebbé teszi a Google számára, hogy olvassa a weboldalt.

Természetesen a Google képes kezelni a hibás HTML-t, már csak azért is, mert a legtöbb HTML-kód, amit a weben találunk egyáltalán nem 100 százalékos. Vagyis a Google-nek képesnek kell lennie arra, hogy ezeket is megfelelően feldolgozza. Ugyanakkor, amikor strukturált adatokról vagy más technikai elemekről van szó – melyek nem feltétlenül láthatóak, viszont fontos részei a forráskódnak -, akkor azoknak validnak kell lenniük.

A témához kapcsolódó kérdés egyébként a Redditen merült fel, ahol a kérdező arra volt kíváncsi, hogy ha a fő HTML-tartalom a kód 5118-as soránál kezdődik, akkor nem jelent-e problémát a Google számára annak feltérképezése?

Mueller ennek kapcsán elmondta, hogy a tartalom pozíciója nem igazán lényeges a HTML-ben, sokkal inkább azzal lehet probléma, hogy mi van körülötte. Adott esetben ez megakadályozhatja vagy legalábbis jelentősen megnehezítheti a Google számára a tartalom feldolgozását.

A HTML fejlécnek mindenesetre „nagyjából” fent kellene lennie, úgy hogy mindenféle JS-kód ez alá kerüljön. Emellett érdemes tesztelni a Search Console-ban, hogy a JS nem zavar-e be. Ez azért fontos, mert a head-szekció gépi olvasásra készült információ, melynek az oldal egy meghatározott részén kell lennie, mégpedig felül, illetve rendezettnek is. A lényeg, hogy a JavaScript kerüljön le – tette hozzá Mueller.

Később egyébként a Google Tag Manager kódjának pozíciójára is rákérdeztek, melynek kapcsán elmondta, hogy „minden helyzet más”. Mindenesetre tesztelni kell a böngészőben és egyéb teszt-eszközökkel.

Korábban Mueller úgy nyilatkozott, hogy a tartalom pozíciója nem igazán számít, ami némileg ellenmond annak, amit Gary Illyes, a Google másik szakembere nyilatkozott, aki szerint a mobilon a tartalom sorrendje és pozíciója is meghatározó rangsorolási szempontból.

Már nem indexeli a Flash-fájlokat a Google

A Google 2019. október 28-án jelentette be, hogy leáll az Adobe Flash fájlok, azaz SWF-fájlok indexelésével. Mint írták, a „Google a továbbiakban nem támogatja a Flasht. Azokon a weboldalakon, ahol Flash-tartalom található, a Google nem vesz tudomást a Flash-tartalomról. A Google leállítja az önálló SWF-fájok indexelését.”

A Flasht 1996-ban indította el az Adobe, a Google pedig 2008 júliusában kezdte indexelni a Flash-fájlokat, vagyis 11 évvel ezelőtt, majd egy évvel később javított ezen, de igazán jól soha nem ment neki a Flash-fájlok indexelése. Igazán népszerű még a ’90-es évek második felében volt a technológia, azóta azonban eltelt jó pár év, melynek során lassan kikopott: először az Apple szakított vele az iPhone-oknál, majd a Chrome a 76-os verziótól, a Firefox a 69-estől felhagyott a megjelenítésével. Így nem túl meglepő, hogy a Google most már leáll az indexeléssel, ha szinte senki számára nem jelenik meg.

A Google azt is megjegyezte, hogy a „legtöbb felhasználó és weboldal semmilyen hatását nem tapasztalja ennek a változásnak”. Arra is kitért, hogy most már a HTML5 révén rendelkezésre áll egy általánosan elfogadott megoldás olyan dolgok létrehozására, mint amit a Flash tudott.

Tehát, ha a weboldalad még használ Flasht, miközben erősen függ a forgalmad a keresőben elért helyezésedtől, akkor érdemes minél előbb lecserélni a Flash-megoldásokat.

II. A robots.txt fájl

Ha befolyásolni akarod a weboldalad indexelését és feltérképezését, akkor a noindex és nofollow metacímkéken kívül a robots.txt-t is használhatod erre a célra. A robots.txt azonban más egyéb célokra is használható, pedig egy sima, szöveges fájl, mely a weboldalad gyökérkönyvtárában található (ha máshol helyezed el, akkor nem vesznek róla tudomást a keresőrobotok). Arról tájékoztatja a keresőrobotokat, hogy hol nézelődhetnek a weboldaladon, és hol nem. Ha megfelelően használod, akkor javíthatod általa a feltérképezési gyakoriságot, mely segítheti a SEO-erőfeszítéseidet.

Mi az a robots.txt fájl?

Amikor az internet még csak gyerekcipőben járt, a fejlesztők kidolgoztak egy megoldást a weboldalak feltérképezésére és indexelésére. Ezt a tevékenységet a robotok és a pókok végezték, melyek bebarangolják a web valamennyi szegletét, hacsak meg nem tiltjuk nekik, hogy valahová betegyék a lábukat. Például egy olyan oldalra, ami éppen átalakítás alatt van.

A világ első keresőmotorjának megalkotója, az Aliweb hozott létre egy megoldást a robotok mozgásának szabályozására, mely 1994-ben készült el, és a Robots Exclusion Protocol nevet kapta. A robots.txt fájl ennek a protokollnak a végrehajtása. A protokollt minden legális robotnak be kell tartania, ugyanakkor a malware-ek, spyware-ek nem törődnek vele, hiszen illegálisan működnek.

Mielőtt egy keresőrobot (például a Googlebot vagy a Bingbot) feltérképezné a weboldalad, először leellenőrzi, hogy van-e az oldalnak robots.txt fájlja, és ha igen, akkor követi a benne található utasításokat. Elsősorban arra használható, hogy meghatározd: a weboldalad mely területeit járják be a botok.

A robots.txt tartalmát Te is megnézheted bármely weboldal esetében. Ehhez csak az URL mögé kell illeszteni a /robots.txt szöveget. Maga a robots.txt fájl a weboldalad gyökérkönyvtárában található, a public_html mappában. Ha megnyitod egy szövegszerkesztőben, akkor tudod is szerkeszteni. Ha mégsem találnád, akkor nincs robots.txt fájlod, és létrehozhatsz egyet.

Miért hasznos a robots.txt fájl?

Robots.txt fájl nélkül remekül meg lehet lenni, nem szükséges egy jól működő weboldalhoz. Ugyanakkor van néhány olyan előny, amit kihasználhatsz vele:

- Megakadályozhatod a botokat, hogy magánjellegű mappákat elérjenek és ellenőrizzenek.

- Vagy akár bármilyen részét a weboldaladnak, így például a belső keresés eredményoldalait.

- Meghatározod vele az oldaltérkép helyét.

- Optimalizálhatod a feltérképezési büdzsét azáltal, hogy az alacsonyabb értékű oldalak (belépési oldal, köszönöm oldal, bevásárlókosár, stb.) elérését korlátozod.

- Ellenőrzés alatt tarthatod a forrásokat. Ez azért fontos, mert amikor egy bot feltérképezi az oldalad, használja a sávszélességed és más szerver-erőforrásokat. Ha egy weboldalon nagyon sok a tartalom és az aloldal, akkor a robotok tevékenysége leterhelheti a szervert. Mivel a robots.txt segítségével bizonyos részektől távol tarthatók a botok, így az erőforrások megmaradnak a valódi felhasználók számára.

- Megelőzheted, hogy indexelésre kerüljenek bizonyos fájlok (képek, pdf-ek, stb.).

Mi szerepel a robots.txt fájlban?

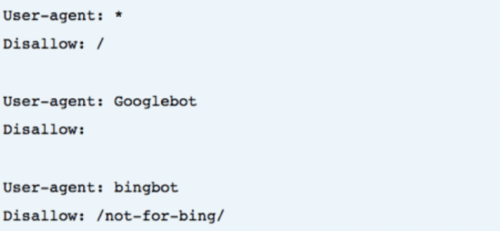

A robots.txt fájlok különböző utasításokat tartalmaznak. Mindegyik egy meghatározott user-agentre vonatkozik. Itt két lehetőség van: vagy valamennyi user-agentre vonatkozik, vagy pedig csak valamely user-agentre. Ez így néz ki:

Minden blokk első sorai a user-agentet határozzák meg, azaz valamelyik botra vonatkoznak, annak pontos nevét tartalmazzák. Ha például a Googlebotnak akarsz utasításokat adni, akkor úgy kezded a blokkot, hogy „User-agent: Googlebot”. A keresőmotorok minden esetben megpróbálják megtalálni azokat az utasításokat, melyek leginkább rájuk vonatkoznak. Minden keresőmotor többféle botot is használ, a leggyakoribbakat itt találod.

Az utasítások közé tartozik a „disallow” – a blokk második sorában szerepel -, mellyel azt határozhatod meg, hogy a weboldalad mely részeihez ne férjenek hozzá a botok. Ha üres, akkor az egész weboldalt szabadon bejárhatják a botok.

Ha ez szerepel benne

User-agent: *

Disallow: /

akkor az azt jelenti, hogy minden botot kitiltasz az oldalról, pedig nem sok különbség van ahhoz képest, hogy engedélyezed az egész oldal bejárását.

Ezzel az utasítással csak egy botot tiltasz ki:

User-agent: Googlebot

Disallow: /

De részletezheted azt is, hogy mely oldalakról kerüljenek kitiltásra a botok:

Disallow: /search

A sitemap utasítással meghatározható az, hogy hol találják az XML oldaltérképet a botok.

Sitemap: https://linkcime.hu/sitemap

Szintén beállítható a feltérképezési késleltetés, vagyis a crawl-delay.

A disallow mellett fontos még a noindex utasítás is, hiszen a disallow még nem akadályozza meg egy oldal indexelését, így az megjelenhet a találati oldalakon. Azt ugyanakkor ennek kapcsán érdemes tudni, hogy a Google nem mindig tartja be következetesen.

A Google tájékoztatója itt olvasható a robots.txt létrehozásától, illetve annak teszteléséről. A Google egyébként legfeljebb 500KB-os fájlt hajlandó megnézni.

Amit el kell kerülni

A robots.txt-ben található utasítások nem arra valók, hogy megpróbálj rejtegetni valamit a botok elől. Nem is érdemes, mert a Google van annyira fejlett, hogy rájöjjön erre. Sőt, sok esetben éppen a takargatási próbálkozással hívod fel a figyelmet valamire, például egy duplikált tartalomra. Amennyiben a duplikált tartalom problémájával állsz szemben, akkor három lehetőséged van:

- átírod a tartalmat

- 301-es átirányítást használsz

- canonical taget használsz

További tippek

- Győződj meg arról, hogy valamennyi fontos oldalad feltérképezhető, míg az értéktelen oldalakat blokkolod a botok elől.

- Ne blokkold az oldalad JavaScript és CSS fájljait.

- Időnként ellenőrizd a robots.txt fájlodat, nehogy olyan véletlen módosítás történjen, amiről nem tudsz.

- A mappáknál és fájlneveknél figyelj a nevek pontos egyezésére!

- A gyökérkönyvtárba helyezd, hogy megtalálható legyen.

- A robots.txt fájl nevének pontosan ennek kell lennie, nincsenek különböző variációk.

- Az érzékeny felhasználói információkat ne robots.txt-vel próbáld meg elrejteni, mert attól még láthatóak maradnak. Egy másik oldal belinkelheti, és így a robotok is meg fogják találni, és indexelik. Ezeknél az oldalaknál külön helyezz el az oldal kódjában noindex meta taget, illetve állíts be jelszót!

- Jelezd az oldaltérkép helyét! Ha aldomaint használsz, akkor mindegyikhez kell egy robots.txt, ahogy a fődomainhez is.

Teszteld a végén!

Ha elkészült a robots.txt fájlod, akkor érdemes tesztelni, mert ebből láthatod, hogy megfelelően működik-e.A Search Console-ban találsz egy olyan lehetőséget, hogy „robots.txt tesztelése”. Itt megnézheted, hogy működik-e a robots.txt fájlod, és megnézheted, hogy az általad kizárt URL-eket eléri-e a bot vagy sem.

Frissítés, 2022.03.29.:

Melyek a leggyakoribb hibák a robots.txt-nél?

Ha hibát követsz el a robots.txt-ben, annak lehetnek káros következményei, de azért nem a világ vége. Ha pedig javítod a hibákat, akkor azt követően gyorsan helyreállnak a dolgok. A Google a webfejlesztőknek írt dokumentumában is azt mondja, hogy a robotok általában nagyon rugalmasak, és a kisebb hibák nem akasztják meg a működésüket az oldalon. A legrosszabb, ami történhet, hogy a hibás vagy nem támogatott utasításokat figyelmen kívül hagyják. Arra is felhívja azonban a figyelmet a Google, hogy nem gondolatolvasó, amikor a robots.txt értelmezéséről van szó. Milyen hibák fordulnak elő gyakran?

A robots.txt nem a gyökérkönyvtárban található

A keresőrobotok csak akkor találják meg a fájlt, amennyiben az a gyökérkönyvtárban van. Erről a legegyszerűbben úgy győződhetsz meg, hogy amikor beírod az url-t, akkor a .hu után csak egy perjel található, majd a robots.txt szöveg. Ha a fájl egy almappába kerül, akkor nem látható a robotok számára.

A karakterek hibás használata

A robots.txt csak két helyettesítő karaktert támogat. Az egyik a csillag *, mely bármely érvényes karaktert helyettesíthet, míg a másik a dollárjel $, mely az url végét jelöli, lehetővé téve, hogy olyan szabályokat alkalmazz, melyek csak az url végére érvényesek (mint például fájltípus-kiterjesztés). Érdemes ezeket a karaktereket óvatosan kezelni, mert könnyen előfordulhat, hogy kitiltod velük a robotokat a weboldaladról.

Noindex a robots.txt-ben

Ez a hiba jellemzően a régebbi weboldalakat érinti. A Google 2019. szeptember 1-jétől leállt le a robots.txt-ben megjelenő noindex szabályok figyelembevételével, a noindex kérést már máshogy kell megoldani, például a robots meta címkével, mely az oldalak head részében található.

Blokkolt szkriptek és stíluslapok

Adott esetben hasznos lehet, ha blokkolod a robotok elől a külső JavaScripteket és CSS-eket. Ugyanakkor a Googlebotnak hozzáférés kell a CSS és a JS fájlokhoz annak érdekében, hogy megfelelően lássa a HTML és PHP oldalakat. Ha a weboldalaid furcsán jelennek meg a találati oldalakon, vagy a Google nem látja őket megfelelően, akkor lehet, hogy blokkolod a robotok hozzáférését a szükséges külső fájlokhoz.

Nincs oldaltérkép url

Az oldaltérképed url-jét elhelyezheted a robots.txt fájlban. Ez az első hely, ahol a Googlebot körül fog nézni, amikor feltérképezi a weboldalad. Így egyből tudni fogja, hogy milyen az oldalad felépítése, melyek a fő oldalak. Ha nincs a robots-txt-ben oldaltérkép link, akkor az nem feltétlenül számít hibának, mégis érdemes lehet elhelyezni a linket a robots.txt fájlban.

Hozzáférés a fejlesztés alatt lévő oldalakhoz

Általában bevett megoldás, hogy disallow utasítással kitiltják a robotokat a robots.txt-ben a weboldal fejlesztés alatt lévő részéről, így a felhasználók nem látják ezeket, amíg el nem készülnek. Ha forgalmat látsz a készülő oldalaid esetében, akkor ezt nem tetted meg. Ugyanakkor ez a tiltás néha benne maradt a robots.txt-ben azt követően is, hogy elkészült az oldal. És akár az egész oldalra érvényes tiltás is benne maradhat a fájlban. Ilyenkor pedig hiába várod a forgalmat vagy a megjelenést a keresőben, ez nem történik meg. Tehát, ha azt látod, hogy „Disallow: /”, akkor ez lesz a hiba.

Miért és hogyan rangsorolja a Google a robots.txt-ben blokkolt oldalakat?

Azért, mert egy oldaladat blokkoltad a robots.txt segítségével, azt még indexelni fogja a Google, ha linkek mutatnak rá. Nem vizsgálja meg a tartalmát, nem is ismeri azt, de az indexbe bekerül, így pedig rangsorolható, és akár jó helyezést is szerezhet.

De mi alapján történik a rangsorolás, ha a Google-nek fogalma sem lehet elvileg arról, hogy mi található az adott oldalon, az mennyire értékes tartalom? A Google szakembere, John Mueller egy Google Webmaster Central beszélgetés során adott választ a kérdésre.

Azt hangsúlyozta, hogy a blokkolt oldal tartalmára természetesen nincs rálátásuk (hiszen betartják azt a szabályt, hogy a robot nem vizsgálja az adott oldalt). És az is igaz, hogy a nem blokkolt oldalakat részesítik előnyben az indexelés során ugyanezen domain alatti oldalaknál. Ugyanakkor a Google vizsgálja és értékeli azokat a linkeket, melyek a blokkolt oldalra mutatnak. Ez alapján fogja tehát meghatározni a Google, hogy hová helyezze a találati oldalon a blokkolt oldalt.

Mint a szakember szavaiból kiderül, ha azt látják, hogy egy blokkolt oldalra értékes linkek mutatnak, akkor az megítélésük szerint „jól működik”, értékes tartalom lehet. Ezért is nem javasolja John Mueller a weboldaltulajdonosoknak, hogy robots.txt-vel blokkolják a botok elől az oldalt, ha azt szeretnék, hogy az teljesen rejtve maradjon. Ettől még ugyanis jó helyet kaphat a találati oldalakon.

Látod a találati oldalakon a robots.txt-det? Akkor komoly gond van a weboldaladdal

Akad néhány olyan weboldaltulajdonos, aki arra panaszkodik, hogy megjelenik a találati oldalakon a robots.txt fájlja vagy épp az XML oldaltérképe. Hiszen ezek indexelési szempontból ugyanolyan URL-ek, mint a többi, és így a tartalmuk indexelhető. Habár speciális szerepük van, ez nem befolyásolja az indexelési állapotukat. Az ugyanakkor mégis gond, ha ezek normál keresésekre (azaz nem a site: keresésekre) megjelennek a találati oldalakon, vagyis rangsorolja őket a Google. John Mueller szerint, ha ez megtörténik, az azt jelzi, hogy nagyon rossz az oldalad, és rendbe kellene rakni.

Mit tehetsz, ha blokkolni akarod a robots.txt-t vagy az XML oldaltérképet? Mueller szerint megoldható a HTTP headerben elhelyezett x-robots-taggel. Persze magában a robots.txt-ben is jelezheted egy „disallow” jelzéssel, hogy ne indexeljék a robotok a tobots.txt-t, de ez valószínűleg már késő, mert mire eljutnak a robots.txt tartalmához, addigra már indexelte is az URL-jét. A lényeg pedig az, hogy ezen oldalak indexelésére nincs szükség, mert más szerepük van. No. A sitemap file is usually just meant for direct usage by programs, it doesn’t need to be indexed. — ? John ? (@JohnMu) November 7, 2019

III. Kulcsszavak

A kulcsszavakkal telezsúfolt oldalak kora véget ért. A kulcsszóhalmozásra érzékeny a Google, ráadásul a keresés jóval kifinomultabbá vált, mintsem át lehetne verni néhány tucat kulcsszó ismételgetésével egy oldalon. Ennek ellenére persze nem lehet azt sem állítani, hogy teljes mértékben figyelmen kívül kellene hagynunk a kulcsszavakat.

Kulcsszókutatás és kulcsszó-stratégia kialakítása

A kulcsszavak keresése még mindig a SEO-kampányok egyik legfontosabb része, habár szerepük mostanra némileg már átértékelődött. Ha egy témában szöveget írsz és a SEO is fontos szempont, akkor érdemes utánanézni, hogy melyik keresési kifejezés iránt mutatkozik nagyobb érdeklődés, és a szöveget erre hangolni.

Nyilván, ha egy – általában rövid, egyszavas – kulcsszó nagyon felkapott, ott nehéz labdába rúgni, ezért is javasolt a specializáltabb, több szóból álló, de még keresett long tail kifejezéseket használni. Ugyanakkor egy átgondolt kulcsszókutatás és oldalstruktúra-felépítés esetén a fő kulcsszavaknak és a long tail kulcsszavaknak is megvan a maguk helye és az ennek megfelelő szerepük.

De hogyan is nézzen ki a kulcsszó-stratégia?

Ahhoz, hogy forgalmat szerezz, fel kell keltened az emberek érdeklődését a weboldalad iránt. Ha el akarod érni, hogy meglátogassák az oldalad, tudnod kell, hogy mit keresnek, milyen kifejezéseket használnak, és milyen tartalomtípusok érdeklik őket. Ez jelenti a kulcsszó-stratégiát.

Általában egyszerűen csak kulcsszókutatást emlegetünk, amikor a megfelelő kulcsszavak összegyűjtéséről van szó, az is fontos, hogy ez miként zajlik, milyen elképzelés, terv mentén. Egy kulcsszó-stratégia minden döntést magába foglal, melyeket a kulcsszókutatás során meg kell hozni. A kulcsszó-stratégia arról szól, hogy miként akarod megcélozni az adott kulcsszavakat most és a jövőben. A kulcsszó-stratégia kialakításához meg kell vizsgálnod nem csak a céged vagy a terméked, hanem a környezetet és a versenytársakat is.

A céged vizsgálata

Egy jó kulcsszó-stratégia azzal kezdődik, hogy mivel foglalkozik a céged, és miért teszi ezt. Mik a céljai? Mi az, amiben egyedi és eltérő? Milyen üzenetet akar kommunikálni? Miért nézi meg bárki is a weboldalad? Minél jobban átlátod a válaszokat ezekre a kérdésekre, annál kevesebb erőforrást fogsz elpazarolni feleslegesen a SEO-nál.

Keresési szándék vizsgálata

A keresési szándék a „miért” minden egyes keresés mögött, ami a weboldaladra vezet. Ismered a közönséged? Az emberek csak információkat keresnek a weboldaladon, vagy hajlandóak is vásárolni tőled? Van arra lehetőség, hogy speciális szándékokat célozz meg arra irányított tartalmakkal? Neked kell eldönteni, hogy mi az a felhasználói szándék, amit ki akarsz szolgálni, és ennek megfelelő tartalmakat kell készíteni az illeszkedő kulcsszavakkal.

Keresd a szavakat!

A szavak állnak a kulcsszókutatás középpontjában. Amikor kulcsszókutatást végzel, akkor bepillantást nyersz abba, hogy milyen kifejezéseket használnak az emberek annak érdekében, hogy megtalálják, amit keresnek. Ha ezt tudod, akkor már csak a felhasználó-központú tartalom elkészítése marad hátra, ami illeszkedik a szándékhoz valamint a Te céljaidhoz.

A versenytársak vizsgálata

Nem elég, ha csak magaddal és a közönségeddel foglalkozol a kulcsszókutatás során. Érdemes egy pillantást vetni a versenytársakra is. Ők mit csinálnak? Milyen helyezést érnek el azon kulcsszavakra, amelyeket Te is megcéloztál? Milyen tartalmakat készítenek? Van arra lehetőséget, hogy jobb tartalmakat készíts? Vagy esetleg más kulcsszavakat kellene megcéloznod, ahol kisebb a verseny?

A keresőmotor vizsgálata

Amikor a konkurenciát vizsgálod, akkor természetesen a keresőt használod erre. Ezek a keresések megmutatják az ő stratégiájukat. Ugyanakkor az is kiderül egy-egy keresésből, hogy mi történik, amikor beírsz egy bizonyos keresési kifejezést. Milyen találatokat dob fel a Google? Hogy néz ki adott keresésre a találati oldal? Térképes találatokat mutat?

A weboldalak számára egyre nagyobb gondot jelent, hogy csökken az átkattintási arány a Google találati oldaliról. Ennek oka, hogy egyből válaszokat kapnak a keresők már a találati oldalról, így felesleges tovább kattintaniuk valamely weboldalra.

Az adatok vizsgálata

Természetesen az adatok vizsgálata jelentős szerepet játszik egy kulcsszó-stratégia sikerében. A Google Analytics vagy a Search Console értékes adatokat kínál a weboldalad teljesítményéről, és a kiaknázható lehetőségekről, így természetesen a kulcsszavakról is.

Frissítés, 2021.12.01.:

Milyen típusú kulcsszavak vannak?

Az előbb már említettük a keresési szándék vizsgálatát, mely meghatározza, hogy milyen kulcsszavakra érdemes optimalizálni. Mélyedjünk el ebben egy kicsit jobban!

A keresési szándékok alapján ugyanis a kulcsszavaknak négy típusát különböztethetjük meg:

- Információs kulcsszavak – amikor az emberek válaszokat akarnak egy kérdésükre

- Navigációs kulcsszavak – amikor az emberek egy bizonyos oldalt akarnak megtalálni

- Kereskedelmi kulcsszavak – amikor az emberek egy márkát vagy szolgáltatást közelebbről meg akarnak ismerni

- Tranzakciós vagy vásárlási célú kulcsszavak – amikor az emberek valamilyen terméket meg akarnak venni

Nézzük részletesebben!

Információs kulcsszavak

Mint látható a felsorolás mindjárt az információs kulcsszavakkal kezdődik. A weboldalak nagyon sokszor optimalizálnak ilyen információs kulcsszavakra, majd aztán nem értik, hogy ezek miért nem hoznak konverziót. Ennek oka, hogy amikor az ezen csoportba tartozó kulcsszavakat a felhasználó beírják a keresőmezőbe, akkor nem vásárolni, hanem információt akarnak.

Tehát lehetsz Te első helyen ezekre a kulcsszavakra, generálhat is neked szép forgalmat, de tranzakciót az nem fog hozni, legfeljebb közvetetten, az ismertebbé válás révén.

Ha egy kulcsszó információs kulcsszó, akkor a Google találati oldalain tudáspanellel, információs dobozzal, gyors válasszal találkozol. De a találatok listáját átböngészve is meg tudod állapítani, hogy ezek inkább tájékoztatni vagy eladni akarnak valamit. Ha előbbi, akkor ne remélj konverziókat az ezen kulcsszóra érkező közönségtől!

Ugyanakkor nem haszontalanok, hiszen mint mondtuk, közvetetten elvezethetnek az értékesítéshez, hiszen megismertetik az emberekkel a márkád, növelik a bizalmat. Igaz, ez lehet, hogy nem megy egyik napról a másikra.

Navigációs kulcsszavak

A navigációs kulcsszó rejtélyesen hangzik, de elég egyszerű a jelentése: ha a felhasználó beír a keresőmezőbe egy cégnevet vagy márkanevet, akkor navigációs keresést hajt végre. Tehát például beírod, hogy Webshark, akkor el akarsz navigálni a Webshark oldalára.

Amikor az emberek navigációs kulcsszavakat használnak, akkor általában már valamennyire ismerik a céget vagy a terméket, de meg akarják nézni a weboldalát vagy meg akarják tudni, hol található az irodája, üzlete. A navigációs kulcsszavak tehát elsősorban akkor hozzák a forgalmat, ha már valamennyire ismert a cég vagy a termék, mert az emberek ekkor keresnek rá.

Kereskedelmi kulcsszavak

Ezek olyan kulcsszavak, melyek bizonyos termékekhez és szolgáltatásokhoz kapcsolódnak, de a felhasználó csak további információt akar egyelőre róluk (összehasonlítás, tesztek, árajánlatok, stb.).

Ezek az információk segítenek abban, hogy jobban megismerjék a terméket vagy szolgáltatást, mielőtt megvásárolnák vagy megrendelnék. Ezek a kulcsszavak általában összehasonlító cikkekkel, értékelésekkel, használati útmutatókkal célozhatók meg. De mivel az ilyen kulcsszavakat akkor használják az emberek, amikor már közel járnak a vásárláshoz, jó lehetőséget kínálnak a konverzió előtt álló közönség elérésére.

Tranzakciós kulcsszavak

A konverzióhoz legerősebben kapcsolódó kulcsszavak a tranzakciós kulcsszavak, melyek már leginkább fizetett hirdetésekkel és jól optimalizált landing oldalakkal működnek együtt, melyeknél csak egy lépés a vásárlás realizálása.

Ilyen keresésre akkor kerül sor, amikor valaki már begyűjtötte a szükséges információkat, meghozta a döntését, és elhatározta, hogy megveszi a terméket. Ezért az ide tartozó keresési kifejezésekbe olyan szavak is sűrűn megjelennek, mint a vásárlás, feliratkozás, akció, ár stb. De jellemző ezekre a kulcsszavakra az is, hogy speciálisak, azaz pontosan megjelenik bennük például a terméknév vagy a termék leírása.

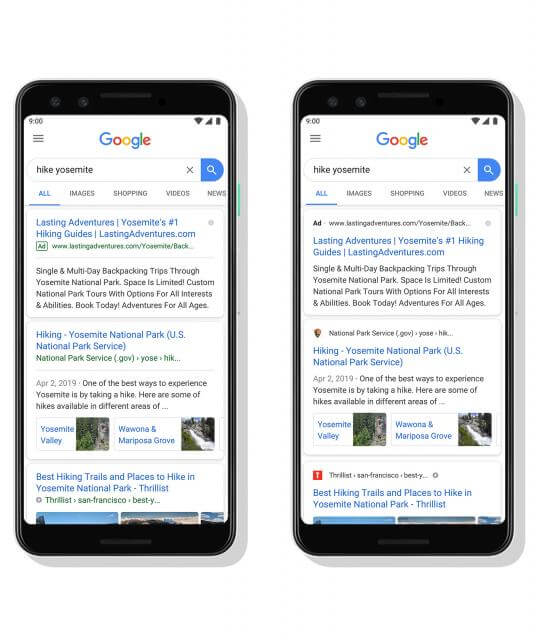

Azt, hogy egy kulcsszó tranzakciós kulcsszó, leginkább az mutatja, hogy termék esetében a találati oldalon shopping hirdetéseket fogsz látni.

MIÉRT NEM A LEGJOBB MEGOLDÁS A GOOGLE KULCSSZÓTERVEZŐJE SEO-RA?

Amikor a kulcsszavak kiválasztásáról van szó egy weboldal keresőoptimalizálásánál, sok-sok tényezőt számításba kell venni. Ezek miatt nem egyszerű a legjobb kulcsszavak kiválasztása, így nem véletlen, hogy sokan egyből a Google, illetve az Ads kulcsszótervezőjéhez nyúlnak, sajnos sok esetben alapszinten, néhány szót bepötyögve, és kizárólagos eszközként használják.

Tehát nem azt akarjuk mondani, hogy értelmetlen lenne használni. A gond ott van, ha ez az egyetlen megoldás kulcsszavaink meghatározásához. A Google kulcsszótervezőjében ugyanis nem érdemes száz százalékosan megbízni.

AZ ADS KULCSSZÓTERVEZŐJE NEM IGAZÁN INTELLIGENS

Ez az eszköz általában nagyon közeli variációkat ad ki, amikor valamit keresünk. Ez alatt azt kell érteni, hogy nagyon leragad az alapszónál, pedig lennének olyan kifejezések, melyek nem ugyanezt a szót tartalmazzák, viszont témájukban kapcsolódnak, relevánsak lennének. Ha mi magunk ezeket nem gyűjtjük össze, nem keresünk rá ezekre, a Google nem fogja ezekre felhívni a figyelmünket.

Pedig amikor az emberek rákeresnek valamire a keresőben, akkor nem feltétlenül úgy jár az agyuk, mint Neked, lehet, hogy más úton közelítik meg ugyanazt a témát. Ezért Neked kell kreatívnak lenned, amikor a Google kulcsszótervezőjével határozod meg a kulcsszavaid körét, mert a kulcsszótervező nem lesz az. Ahhoz bele kell mélyedni az adott témába, a kapcsolódó blogbejegyzésekbe, cikkekbe, videókba, hogy a legjobb kulcsszavakat találd meg.

MINDENKINEK UGYANAZOKAT A KULCSSZAVAKAT DOBJA

Ez azt jelenti, hogy akárki is keres variációkat egy-egy szó kapcsán, mindenki ugyanazokat a kifejezéseket kapja válaszul a Google-től, azaz nem személyre szabottan a Te számodra, a weboldalad számára legjobb kulcsszóötleteket fogod megkapni a kulcsszótervezőtől.

Ezért érdemes bevetni olyan egyéb kulcsszótervező eszközöket, mint például a Keyword Tool és társai, és mint mondtuk: a kreativitásodat, de legalábbis nem teljes mértékben a Google kulcsszótevezőjére hagyatkozni.

Természetesen nem muszáj minden szöveget kulcsszóra optimalizálni. Lehetnek olyan bejegyzéseink, melyeket kifejezetten a keresőnek hozunk létre, és ez egy állandó forgalmat jelent az oldalnak, míg más bejegyzések inkább csak aktuálisak vagy más miatt fontosak nekünk.

Hol helyezzük el a kulcsszavainkat?

Kulcsszavak a címsorban

A kulcsszót tanácsos elhelyezni az oldal meta címsorában, azon belül is általában az első helyet célozzuk meg. De az is fontos, hogy a címsor érdekes, figyelemfelkeltő is legyen, mivel meg fog jelenni a találati listán a többi találat között, és mi azt várjuk, hogy kattintsanak rá. Ugyanez igaz a meta descriptionre, melyet nem vesz figyelembe a rangsorolásnál a Google, viszont az olvasók érdeklődését fel lehet kelteni vele.

Attól egyébként nem kell tartani, hogy a Google ferde szemmel néz ránk, ha túl lendületesen használjuk a címsorban vagy a leírásban a kulcsszavunkat. Legalábbis a Google szakembere, John Mueller így nyilatkozott 2020. december 11-én a Google Search Central SEO live stream során. Itt jegyezte meg ugyanis egy SEO-s azt, hogy ő azt látja: a kis cégek mindig teletömik a kulcsszavaikkal a címsorokat és a leírásokat, annak ellenére, hogy ez nem javasolt. Egy példát is említett, mely így hangzott: “wedding flowers Brighton, funeral flowers Brighton, anniversary flowers Brighton, birthday flowers Brighton”. Ugyanakkor értetlenségét fejezte ki azzal kapcsolatban, hogy hasonló leírások és címsorok jó helyeken jelennek meg a találati oldalakon.

Esztétikailag ugyan valóban nem néz ki jól, és hát túl intelligens megoldásnak sem mondható, ugyanakkor Mueller jelezte, hogy a meta címsorban és a meta leírásban lévő kulcsszóhalmozás nem megy szembe a Google irányelveivel. Ezt a technikát ugyanis a Google nem találja problémásnak.

Ami persze nem jelenti azt, hogy különösebben javasolna a használatát, hiszen a kulcsszóhalmozás által csak egy értelmetlen címet kapunk, amit nehezebb felfognia a felhasználóknak. Mueller szerint az ilyen cím nem igazán ösztönzi kattintásra a felhasználót, márpedig az lenne a lényeg. Ezért ő azt mondja, hogy elsősorban olyan címet és leírást kell megadni, ami kattintásra készteti az embereket, leginkább azzal, hogy pont azt kínálja a felhasználónak, amire az rákeresett. Az, hogy telezsúfoljuk kulcsszavakkal, nem ebbe az irányba mutat, ráadásul a helyezését sem javítja a találati oldalakon.

Miért írja át a Google a weboldalaid címeit? És mit tehetsz ez ellen?

Nem mindenkinek tetszik, hogy a Google a találati oldalon időnként nem azzal a címmel vagy leírással jeleníti meg az egyes weboldalakat, mint amit a tulajdonos meghatározott a metacímkénél. Ezért nekiszegezték a kérdést a Google egyik szakemberének, hogy mikor hagyja már abba ezt a gyakorlatot a cég.

Gary Illyes pedig erre határozottan kijelentette, hogy a Google soha sem fogja abbahagyni a címek átírását. És hogy mi erre az oka? Az, hogy úgy látják, nagyon sok a borzasztó cím a weboldalaknál, melyeket egész egyszerűen nem akarnak megmutatni a felhasználóknak, mert attól tartanak, hogy nem kattintanának az egyébként hasznos tartalomra. Ráadásul van egy rakás olyan weboldal is, amelynél egyáltalán nem állítottak be címet a tulajdonosai, így ezt pótolni kell.

Egy másik alkalommal ugyanakkor jelezte, hogy a Google csak ritkán írja újra a címeket, de amennyiben átírja, akkor az annak a jele, hogy még dolgoznod kellene a címen.

Korábban is hasonlóképpen nyilatkozott: mint mondta, úgy érzik, nem tudnak hasznos találatokat adni a felhasználóknak, ha nem így tesznek. Annál is inkább, mert állítása szerint vizsgálataik azt mutatják, hogy a felhasználók előnyben részesítik a Google által átírt címeket. Úgyhogy ne is reméljük, hogy valaha is felhagy ezzel a gyakorlattal a kereső – szögezte le Gary Illyes.

Amit ebből kiemeltünk fentebb, és fontos is hangsúlyozni, hogy ha a Google átírja egy címsorodat, akkor neked is végig kellene gondolnod, hogy az-e a megfelelő címsor.

Nyilván sok dologban igaza van a szakembernek – bár a weboldaltulajdonosok szubjektív megítélése szerint nem olyan ritkán kerül sor a címsorok átírására a Google részéről, mint ahogy azt Gary Illyes állítja -, hiszen valóban akad rosszul beállított meta cím a weboldalakon. Gyakran előfordul például, hogy minden egyes oldal címe a weboldal nevével kezdődik, vagy pedig egyszerűen a weboldal neve ismétlődik minden egyes oldalon, szóval van néhány eset, amikor elrontják a címadást a weboldalak tulajdonosai. És ha a kereső felhasználók szemszögéből nézzük a dolgot, akkor érthető, hogy nem kattintanak például arra a címre, hogy “homepage”.

Az is megfigyelhető egyébként, hogy a Google a szerint változtatja egy adott oldalnak a címét, hogy milyen kifejezéssel történik a keresés. Ennek oka nyilván az, hogy az adott keresésre optimalizált címek hatására javul az átkattintási arány, még akkor is, ha egyébként remek címet sikerült az oldalnak adni.

Illyes egyébként azt is jelezte, hogy nem tervezik olyan eszköz bevezetését, amivel megelőzhető lenne a címek átírása. Attól félnek ugyanis, hogy ez visszaélésekre adhat okot, például kulcsszóhalmozáshoz vezethet. Végül pedig azt is megemlítette azoknak a weboldaltulajdonosoknak és SEO-soknak, akik elégedetlenkednek a Google címátírásaival, hogy küldhetnek visszajelzést a Google számára, ha nem tetszik nekik az átírt cím.

Kulcsszavak a címekben és alcímekben

Hosszabb szövegeinket érdemes alcímekkel is ellátni, nem csak az átláthatóság kedvéért, hanem mert a Google kiemelt figyelmet fordít a címsorokra, illetve az ezekben elhelyezett szavakra, így adott esetben a kulcsszavakra. Jól tesszük tehát, ha az alcímekbe is elejtünk belőlük egyet-kettőt, annak ellenére, hogy ennek rangsorolási tényezőként ma már nincs jelentősebb szerepe.

Kulcsszavak az első bekezdésben

A következő kiemelt hely a szöveg első bekezdése, azaz leadje, de legalábbis az első száz szó között szerepelnie kellene kulcsszavunknak. Ezen túl viszont nem is nagyon kell erőlködni az elhelyezésen, még egyszer-kétszer érdemes szerepeltetni, illetve inkább a szinonimáit használni. Ami fontos, hogy a szöveg tartalma összhangban legyen a kulcsszóval, tehát arról a témáról íródjon, amiről a kulcsszavunk is szól.

Mit tegyél, ha a Google rossz oldaladat jeleníti meg egy kulcsszóra?

Ez az a helyzet, amikor van egy aloldalad, amit egy keresési kifejezésre optimalizálsz, de amikor a felhasználók a Google keresőjében rákeresnek a kulcsszóra, akkor nem az az oldal jelenik meg, amit Te szerettél volna megjeleníteni. Ismerős a helyzet? Mit tehetsz ilyenkor?

1. Határozd meg a felhasználói szándékot!

- Az a célja, hogy vásároljon?

- Meg akar találni egy bizonyos oldalt?

- Információt akar?

Három eltérő szándékről beszélünk: vásárlási, navigációs és információs célról. Meg kell vizsgálnod, hogy a kulcsszavadra a Google milyen találati oldalt ad ki, milyen jellegűek az ott felsorolt oldalak. Ha a Te célod és a felhasználói szándék nincs összhangban, akkor az adott kulcsszó nem fog működni.

2. Tedd rendbe a weboldalad tartalmát!

Ha a tartalmad megfelel a felhasználói szándéknak, tehát mondjuk a felhasználó információt akar, Te pedig választ adsz egy kérdésre, akkor a következő lépés, hogy a megjelenő tartalmat optimalizáld! Fuss át a következő kérdéseken:

- A kulcsszó szerepel az oldal meta címsorában?

- Megjelenik a meta leírásban?

- Megfelelő a tartalom hosszúsága az első 10 vagy 20 helyezetthez képest?

- A konkurencia használ olyan kapcsolódó kulcsszavakat, melyeket Te nem?

- A tartalom válaszol a felhasználó kérdésére?

3. Tedd rendbe a belső linkeket!

A belső linkek mondják meg a Google-nek, hogy melyik oldal fontos, és melyik kevésbé. Tehát, ha van egy oldalad, amit szeretnél megmutatni a keresőben, akkor arra linkelned kell más oldalaidról. Lehetőleg olyan oldalakról, melyek azonos témáról szólnak, például mert egy kapcsolódó long tail kulcsszóra optimalizáltad őket. Próbálj találni vagy létrehozni pár ilyen oldalt, és hivatkozz a fontos oldaladra. Használd a horgonyszövegekben a kulcsszót, mert emiatt nem büntet a Google, csak jobban megérti az oldal témáját!

4. Szerezz külső linkeket!

A linkek fontosságáról már volt szó, így ezt nem ismételjük el. Az az oldalad, amelyre több és értékesebb külső link mutat, jobb helyezést ér el. A linkek azt mutatják a Google-nek, hogy melyik aloldalad milyen értékes.

5. Nézd meg az analitikát!

Ez azért érdekes, mert a magas visszafordulási aránnyal, rossz átkattintási és konverziós aránnyal rendelkező oldalak általában rosszul teljesítenek a keresőben is. Na, nem azért, mert bármelyik mérőszám közvetlen rangsorolási tényező lenne a Google számára, de az összefüggés létezik. Hasonlítsd tehát össze azt az oldalad, mely megjelenik a keresőben, azzal, amelyiket szeretnéd, ha megjelenne, és ennek fényében változtass az oldal kialakításán és tartalmán, hogy javuljanak a számok.

Végül pedig ugyanezeket a módszereket ellentétesen használva leronthatod a nem megfelelő oldalad helyezését is, vagy ha minden kötél szakad, akkor jelezheted azt is egy noindexszel, hogy ne indexelje az oldalt a Google. Ezzel pedig eltűnik a találati oldalakról. Ugyanakkor azt is megteheted, hogy egy 301-es átirányítást adsz hozzá a fontos oldaladra mutatva.

Mit tehetsz, ha van egy kulcsszóra optimalizált alodalad, mégis a főoldalad jelenik meg a keresőben?

Egy ősrégi probléma, amivel valószínűleg nagyon sokan találkoztak már: egy fontos kulcsszóra létezik egy weboldalnak olyan aloldala, mely rengeteg információt tartalmaz és kifejezetten hasznos lehet a felhasználók számára, a keresőben az adott kulcsszóra keresve mégsem ez az oldal jelenik meg, hanem a főoldal. Ami viszont egy teljesen általános oldal a keresést tekintve, igazából nem ad választ a felhasználó kérdésére, mégis ezt jelenít meg a Google.

A kérdés már számtalanszor felmerült, de nemrég nekiszegezték ismét John Muellernek, a Google szakemberének, aki válaszolt is a Twitteren. Nem mondott persze semmi meglepőt, hanem a papírforma szerinti választ adta, miszerint „ez rendszerint annak a jele, hogy a főoldalad számottevően erősebb a weboldaladon belül”. Mit jelent ez az érintett aloldalra nézve? Azt hogy nem mutat elég erős jelzéseket a Google felé, például lényegesen alacsonyabb a PageRankje, mint a főoldalé, vagy hiányoznak egyéb jelzések, melyek alapján komolyan vehetné a Google.

John Mueller a megoldásra kitérve mindössze annyit tudott mondani, hogy a problémát olykor megoldja az idő. Tehát egy idő után az emberek felfedezik az oldalt, elkezdik ajánlani egymásnak (ami gyakorlatilag azt jelenti, hogy linkelik). Azt is hozzátette azonban, hogy néha arról van szó, hogy szuper-világosnak kell lenned a weboldaladon belül. Usually that’s a sign that your homepage is just significantly stronger within your website. Sometimes that’s a matter of time (as people discover your detailed page & recommend it), sometimes it’s also a matter of you being super-clear within your site. — ? John ? (@JohnMu) November 4, 2020

Sok mindent tehát nem lehet tenni, leginkább követni a korábban, a fejezetben leírt tanácsokat, kihagyva természetesen azt, amikor a keresésre megjelenő oldaladnál noindex jelzést alkalmazol, mert az mégsem lenne szerencsés a főoldalad esetében.

Mit mond a Google a kulcsszavak használatáról?

Van egy hiedelem SEO-s körökben, miszerint ha egy bizonyos arányban használunk kulcsszavakat egy weboldalon, akkor a Google algoritmusa arra jól reagál. Ezért is találhatunk olyan szoftvereket a piacon, melyek bizonyos kulcsszóarányt javasolnak. Ez a hiedelem egyébként még a keresőmotorok egy korai időszakába, a Google előtti időkbe vezethető vissza.